谷歌首次推出根据提示生成用户界面设计的人工智能工具

2025 年谷歌 I/O 大会的第一天已经结束,随之而来的是几项公告,如 Gemini 模型的更新、谷歌搜索中的人工智能模式得到更广泛的推广,以及用于制作媒体的新的生成式人工智能工具。谷歌实验室推出了一项名为 “Stitch” 的新实验,旨在消除从设计用户界面到实际运行代码之间的崎岖道路。

Stitch 的基本原理是将简单的英文提示甚至图片快速转化为用户界面设计和前端代码。谷歌表示,该工具 “利用 Gemini 2.5 Pro 的多模态功能,在设计和开发之间创建了一个更加流畅和集成的工作流程”。

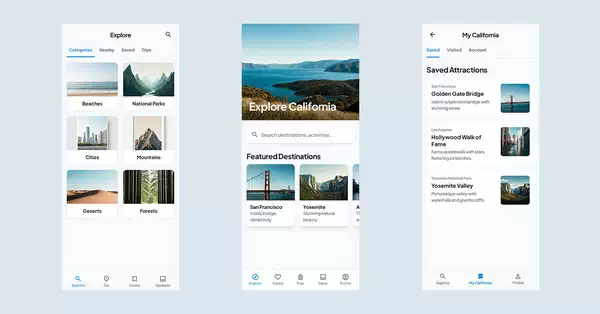

那么,Stitch 究竟能做些什么呢?首先,你可以描述自己想象中的应用程序,加入配色方案或想要的体验等细节,Stitch 就会为你设计出一个可视化界面。如果你已经有了一些可视化的东西,比如一张餐巾纸草图、一张你喜欢的截图,或者一些基本的线框,你可以把这些图片输入到 Stitch,它就会尝试把它转化成数字用户界面。谷歌还解释说,Stitch 是专为快速更改和尝试不同想法而设计的,它可以让你生成大量的设计选项,让你随意摆弄,直到看起来合适为止。

视频地址(需魔法):https://youtu.be/q39uczIW_MY

一旦你对设计感到满意,Stitch 会提供几种关键的方法来推进实际的开发工作。谷歌给出了答案:

- 粘贴到 Figma:您生成的设计可以无缝粘贴到 Figma,以便轻松进一步优化、与设计团队合作以及集成到现有设计系统中。

- 导出前端代码:Stitch 会根据您的设计生成干净、功能齐全的前端代码,因此您有一个功能齐全的 UI。

以用户界面生成为目标的工具并不是全新的;例如,Vercel 的 v0 也允许开发人员根据提示生成用户界面组件并对其进行迭代。不过在 v0 的案例中,它与 Figma 的核心交互方式有所不同,主要工作流程是将 Figma 设计导入并转换为代码,而不是让 Stitch 直接将人工智能生成的设计输出到 Figma 以供进一步完善。您可以在 Stitch 的官方网站上试用它:

https://stitch.withgoogle.com/

评论功能已关闭